摘要:在最新的研究中,深度学习领域的权威Yoshua Bengio及其团队提出了一种精简版的递归神经网络(RNN),这一创新使得传统RNN的性能可与当前领先的Transformer模型相媲美。这项研究通过去除LSTM和GRU中的隐藏状态依赖,实现了高效的并行训练,显著提升了处理长序列的速度。文章详细介绍了这一突破性研究的背景、方法、实验结果及其对深度学习领域的潜在影响。

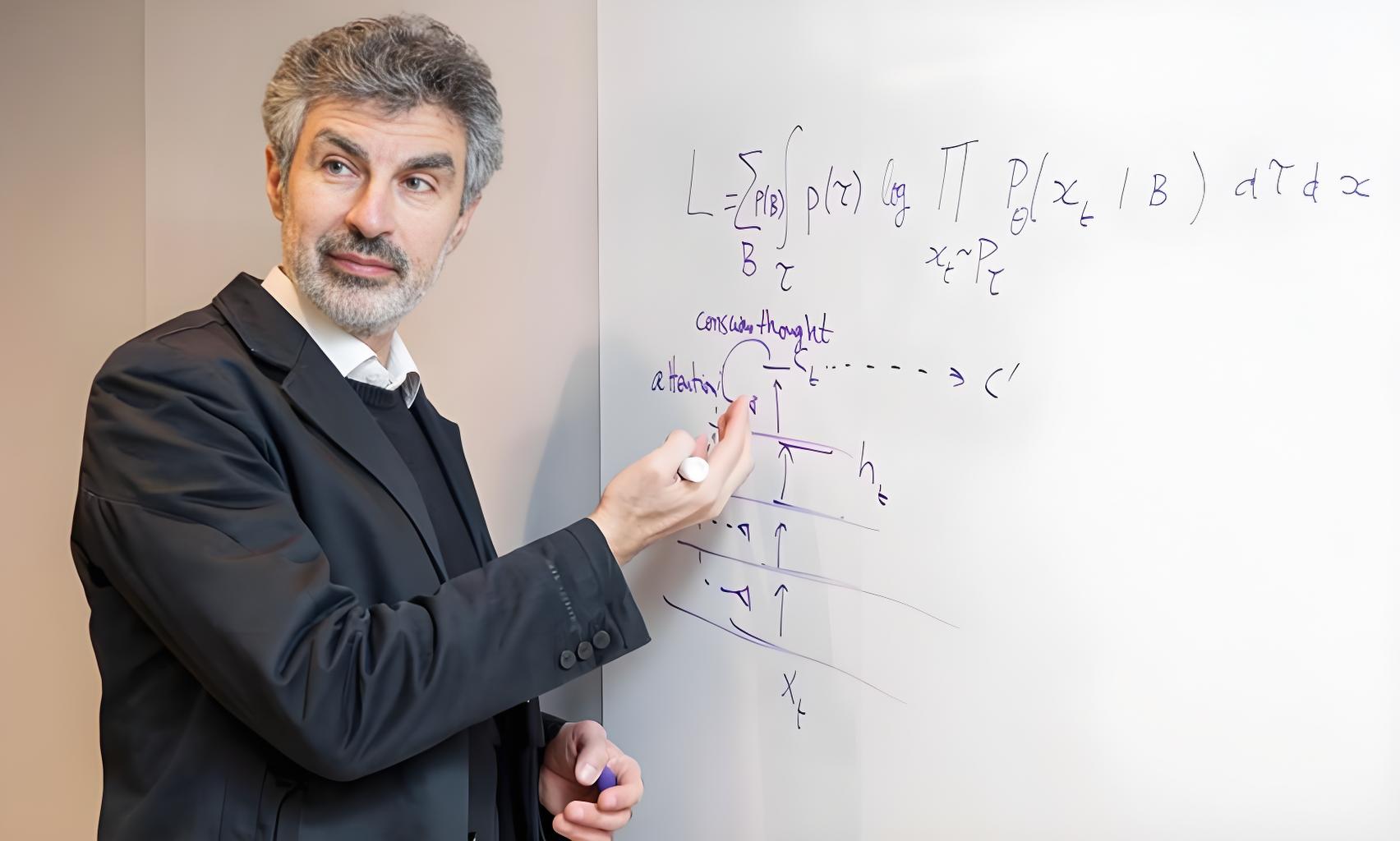

在深度学习的广阔领域中,Yoshua Bengio的名字无疑是一个重量级的标签。作为深度学习三巨头之一,Bengio教授的最新研究再次引起了学术界和工业界的广泛关注。他的团队在论文《Were RNNs All We Needed?》中提出了一种精简版的递归神经网络(RNN),这一创新使得传统RNN的性能可与当前领先的Transformer模型相媲美。

传统RNN的局限性与改进

传统的RNN模型,如长短期记忆网络(LSTM)和门控循环单元(GRU),在处理序列数据时表现出色。然而,这些模型在训练过程中需要时间反向传播(BPTT),这限制了它们的训练速度。Bengio团队的研究表明,通过移除LSTM和GRU中的隐藏状态依赖,可以显著提高这些模型的训练效率。

在这一过程中,Bengio团队提出了minLSTM和minGRU两种精简版的RNN模型。这些模型不仅在训练时所需的参数量大幅减少,而且可以完全并行化,从而在处理长序列时更加高效。

minGRU和minLSTM的创新之处

minGRU模型的改进主要分为两步。首先,团队去除了之前隐藏状态的依赖,使得更新门和候选隐藏状态的计算仅依赖于当前时刻的输入,而不依赖于前一时刻的隐藏状态。这一改进使得minGRU的每一时刻的计算可以独立于其他时刻并行执行。其次,团队去除了候选状态的范围限制,将其替换为一个无需激活函数的线性变换,进一步简化了模型。

minLSTM模型的改进则分为三步。除了与minGRU相同的前两步改进外,minLSTM还通过归一化遗忘门和输入门,确保了其输出在时间上是独立的。这一改进有助于优化过程中的数值稳定性,并确保了模型在处理长序列时的高效性能。

实验结果与研究意义

Bengio团队的实验结果表明,精简版的RNN模型在训练效率方面与Mamba模型等相比具有显著优势。这些指标是在T4 GPU上,以64的批次大小进行测量的。此外,在Shakespeare语言建模任务中,简化RNN模型展现出了良好的有效性和高效率,特别是在需要快速训练和部署的应用场景中。

这项研究的意义在于,它为处理长序列任务提供了一种新的、高效的解决方案。尤其是在资源有限的场景下,精简版的RNN可能是理想的选择。Bengio团队的研究提出了一个问题:“Were RNNs All We Needed?” 这表明,经过简化的RNN可能仍然是解决某些深度学习任务的关键。

华人学者的贡献

值得注意的是,这项研究的一作是一位华人学者Leo Feng。他师从Bengio,目前是蒙特利尔大学的博士生,并在Borealis AI进行研究实习。Leo Feng的研究范围包括元学习和高效模型的设计,他的参与为这项研究增添了多元化的视角。

结论

Yoshua Bengio团队的这项研究不仅在技术上取得了突破,也为深度学习领域提供了新的思考。精简版的RNN模型的性能可与Transformer等最新模型相媲美,这可能会改变我们对序列模型的理解和应用。随着深度学习技术的不断发展,我们期待看到更多这样的创新研究,推动人工智能领域向前发展。